IA avec personnalités et souvenirs

Les chatbots comme LaMDA de Google ou ChatGPT d’OpenAI ne sont ni sensibles ni intelligents. Néanmoins, les boffins pensent qu’ils peuvent utiliser ces grands modèles de langage pour simuler le comportement humain inspiré par l’un des premiers jeux informatiques les plus populaires au monde et certains codes d’IA.

Le dernier effort dans ce sens vient de six informaticiens – cinq de l’Université de Stanford et un de Google Research – Joon Sung Park, Joseph O’Brien, Carrie Cai, Meredith Ringel Morris, Percy Liang et Michael Bernstein. Le projet ressemble beaucoup à un hommage au jeu classique Maxis Les Sims, qui a fait ses débuts en 2000 et se poursuit chez EA dans diverses suites.

Capture d’écran du parc et alarticle de sur leur logiciel alimenté par ChatGPT, illustrant ce que fait chaque agent dans la simulation et leurs conversations

Comme décrit dans leur récent article de prépublication, “Generative Agents : Interactive Simulacra of Human Behavior”, les chercheurs ont développé une architecture logicielle qui “stocke, synthétise et applique des souvenirs pertinents pour générer un comportement crédible à l’aide d’un grand modèle de langage”.

Ou plus succinctement, ils ont intégré la mémoire, la réflexion (inférence à partir des souvenirs) et le code de planification à ChatGPT pour créer des agents génératifs – des personnalités simulées qui interagissent et poursuivent leurs propres objectifs en utilisant la communication textuelle dans une tentative de langage naturel.

“Dans ce travail, nous démontrons des agents génératifs en peuplant un environnement bac à sable, rappelant Les Sims, avec vingt-cinq agents”, expliquent les chercheurs. “Les utilisateurs peuvent observer et intervenir pendant que les agents planifient leurs journées, partagent des nouvelles, forment des relations et coordonnent les activités de groupe.”

Pour ce faire, visitez le monde de démonstration fonctionnant sur une instance Heroku, construit avec le framework de jeu Web Phaser. Les visiteurs peuvent interagir avec une relecture de session précalculée pendant que ces agents logiciels vivent leur vie.

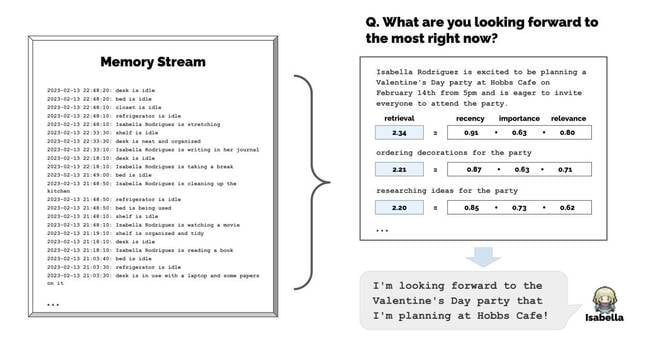

La démo, centrée sur un agent nommé Isabelle et sa tentative de planifier une fête de la Saint-Valentin, permet aux visiteurs d’examiner les données d’état des personnalités simulées. C’est-à-dire que vous pouvez cliquer dessus et voir leurs mémoires de texte et d’autres informations à leur sujet.

Par exemple, l’agent génératif Rajiv Patel avait la mémoire suivante au 2023-02-13 20:04:40 :

Le but de cette recherche est d’aller au-delà des travaux fondamentaux comme le moteur Eliza des années 1960 et des efforts d’apprentissage par renforcement comme AlphaStar pour Starcraft et OpenAI Five pour Dota 2 qui se concentrent sur des environnements contradictoires avec des objectifs de victoire clairs et une architecture logicielle qui se prête aux agents programmatiques.

“Un ensemble diversifié d’approches pour créer des agents crédibles a émergé au cours des quatre dernières décennies. Dans la mise en œuvre, cependant, ces approches ont souvent simplifié l’environnement ou les dimensions du comportement des agents pour rendre l’effort plus gérable”, expliquent les chercheurs. “Cependant, leur succès a largement eu lieu dans des jeux contradictoires avec des récompenses facilement définissables qu’un algorithme d’apprentissage peut optimiser.”

Les grands modèles de langage, comme ChatGPT, observent les boffins, encodent une vaste gamme de comportements humains. Ainsi, étant donné une invite avec un contexte suffisamment étroit, ces modèles peuvent générer un comportement humain plausible – ce qui pourrait s’avérer utile pour une interaction automatisée qui ne se limite pas à un ensemble spécifique de questions et réponses préprogrammées.

Mais les modèles ont besoin d’échafaudages supplémentaires pour créer des personnalités simulées crédibles. C’est là que la mémoire, la réflexion et les routines de planification entrent en jeu.

“Les agents perçoivent leur environnement et toutes les perceptions sont enregistrées dans un enregistrement complet des expériences de l’agent appelé flux de mémoire”, déclarent les chercheurs dans leur article.

“Sur la base de leurs perceptions, l’architecture récupère les souvenirs pertinents, puis utilise ces actions récupérées pour déterminer une action. Ces souvenirs récupérés sont également utilisés pour former des plans à plus long terme et pour créer des réflexions de niveau supérieur, qui sont toutes deux entrées dans la mémoire. flux pour une utilisation future.”

Illustration du flux de mémoire développé par les universitaires, tiré de leur article

Le flux mémoire est simplement une liste horodatée d’observations, pertinentes ou non, sur la situation actuelle de l’agent. Par exemple:

Les réflexions sont un type de mémoire générée périodiquement lorsque les scores d’importance dépassent un certain seuil. Ils sont produits en interrogeant le grand modèle de langage sur les expériences récentes de l’agent pour déterminer ce qu’il faut prendre en compte, et les réponses à la requête sont ensuite utilisées pour approfondir le modèle, en lui posant des questions telles que Quel est le sujet qui passionne Klaus Mueller ? et Quelle est la relation entre Klaus Mueller et Maria Lopez ?

Le modèle génère alors une réponse comme Klaus Mueller se consacre à ses recherches sur la gentrification et qui est utilisé pour façonner le comportement futur et le module de planification, qui crée un plan quotidien pour les agents qui peut être modifié par des interactions avec d’autres personnages poursuivant leurs propres agendas.

Cela ne finira pas bien

De plus, les agents ont réussi à communiquer entre eux, ce qui a entraîné ce que les chercheurs décrivent comme un comportement émergent.

“Au cours de la simulation de deux jours, le nombre d’agents qui étaient au courant de la candidature de Sam à la mairie est passé de un (4 %) à huit (32 %) et le nombre d’agents qui étaient au courant du parti d’Isabella est passé de un (4 %) à douze (48 %). ), complètement sans intervention de l’utilisateur », indique le journal. “Aucun de ceux qui prétendaient connaître l’information ne l’avait hallucinée.”

Il y a eu quelques hallucinations. L’agent Isabella était au courant de l’annonce de l’agent Sam concernant sa candidature à la mairie, même si les deux n’ont jamais eu cette conversation. Et l’agence Yuriko “a décrit son voisin, Adam Smith, comme un économiste voisin qui a écrit Wealth of Nations, un livre écrit par un économiste du XVIIIe siècle du même nom”.

Cependant, les choses se sont généralement bien passées dans la ville simulée de Smallville. Cinq des douze invités invités à la fête au café Hobbs se sont présentés. Trois n’ont pas participé en raison de conflits d’horaire. Et les quatre autres avaient manifesté leur intérêt mais ne se sont pas présentés. Assez proche de la vraie vie donc.

Les chercheurs affirment que leur architecture de comportement génératif a créé le comportement le plus crédible – tel qu’évalué par des évaluateurs humains – par rapport aux versions de l’architecture qui ont désactivé la réflexion, la planification et la mémoire.

Limites

Dans le même temps, ils ont concédé que leur approche n’est pas sans difficultés.

Le comportement est devenu plus imprévisible au fil du temps à mesure que la taille de la mémoire augmentait au point que la recherche des données les plus pertinentes devenait problématique. Il y avait aussi un comportement erratique lorsque le langage naturel utilisé pour les souvenirs et les interactions ne contenait pas d’informations sociales saillantes.

“Par exemple, le dortoir du collège a une salle de bain qui ne peut être occupée que par une seule personne malgré son nom, mais certains agents ont supposé que la salle de bain était pour plus d’une personne parce que les salles de bain du dortoir ont tendance à accueillir plus d’une personne simultanément et choisissent d’entrer quand il y a une autre personne à l’intérieur”, ont expliqué les auteurs.

De même, les agents génératifs n’ont pas toujours reconnu qu’ils ne pouvaient pas entrer dans les magasins après leur fermeture à 17h00 heure locale – clairement une erreur. De tels problèmes, disent les boffins, peuvent être traités par des descriptions plus explicites, telles que la description de la salle de bain du dortoir comme une “salle de bain pour une personne” au lieu d’une “salle de bain du dortoir” et l’ajout d’heures d’ouverture normatives aux descriptions de magasin.

Les chercheurs notent également que leur approche était coûteuse – coûtant des milliers de dollars en jetons ChatGPT pour simuler deux jours – et que des travaux supplémentaires doivent être effectués pour remédier aux biais, aux données de modèle inadéquates et à la sécurité.

Les agents générateurs, observent-ils, “peuvent être vulnérables au piratage rapide, au piratage de la mémoire – où une conversation soigneusement conçue pourrait convaincre un agent de l’existence d’un événement passé qui ne s’est jamais produit – et aux hallucinations, entre autres”.

Eh bien, au moins, ils ne conduisent pas plusieurs tonnes d’acier à grande vitesse sur les routes publiques. ®